“软件定义”时代来临,听大咖解析AV发展趋势!

12月17日,方图杯·2021年度声光视讯智联产业大会暨第十七届慧聪品牌盛会成功举办!

大会特别邀请了中国演艺技术协会专家、QSC北亚区技术经理兆翦,易科国际副总裁、北京InfoComm品牌大使KANE

ZHANG,NETGEAR中国AV解决方案专家、SDVOE中国副秘书长郭浩航,就《“软件”定义AV——AV发展的新思维》的主题,为大家洞察行业大势、解码发展机遇!

郭浩航处在物联网阶段,要拥抱“软件定义”

NETGEAR中国AV解决方案专家、SDVOE中国副秘书长郭浩航

各位有没有发现在过去的几年里,公司里研发人员的薪资飞涨?因为这个世界正在发生“软件化”的发展变更。

从IT的角度来看,最开始是进入SDN(软件定义网络)的时代。为什么会进入这个时代?我们这些人做网络做了这么多年,回头发现自己变成搬箱子的了。真正的应用,大家都谈用户体验,追求简单化、智能化、一键切换,大家玩手机也没再看过说明书。为什么能够做到这样?因为软件帮我们实现了最底层最复杂的那部分,所以我们可以有最简单的界面可用,这些都得益于软件的定义。

发展到后来进入了AV的时代。软件定义跟AV有什么关系?现在AV系统动不动就跑IP网络,音频变成dante、视频变成SDVOE、H.265,有各种技术在里面。大家把产品卖给客户时,不再是卖硬件,而是卖软件系统,系统里面有各种操作界面,大家开始PK界面里面的东西。这整个变迁在AV的网络里也发生过。

在IT里面,数据中心(服务器)这个领域,以前有个非常大的厂商叫IBM,有个非常大的存储厂商叫EMC,但现在大家都很少看到了。因为后来出现了一个通用性的硬件,就是现在各个公司里面的各种服务器、云平台都用的X86平台。这个平台将所有的应用都变成硬件标准化,而硬件是通用的。那接下来厂家要做的事情就是把它变“软”,请软件工程师来开发软件,由此提升硬件的价值。

在监控领域,我第一次接触IP监控时,有安讯视、三星、博世等很多厂商,这些摄像头买回来之后,就只能一直用同一家的产品,因为每个厂家的接口跟别的都不对接。直到后来民族品牌崛起,有很多技术兼容,出现了一个叫onvif的技术,这个技术把所有的硬件都开了一个标准的接口,得益于这种接口,现在很多做监控、摄像机的民族品牌,一上来就可以控制各种品牌的摄像机。那么现在需要干嘛呢?需要去编大数据、数据分析的软件,呈现出可视化的3D,这些是软件工程师的工作,所以还是重在软件。

现在来看音视频整个领域里面,软件定义或者说这整个的进程发展到什么地步?我们现在看到的发展进程,是先做了数字化,所有音频视频都变成数字化;之后变成IP化,每个东西都变成一个IP地址;接下来就是去做标准的接口,有一个标准的接口可以大家打通;最后就是软件定义,可以编出各种各样的应用。这也是现在为什么各行各业都在推软件定义的原因。所以我们现在会看到,做音视频系统只需要开发一套硬件,之后通过编不同的软件就可以用到各行各业,比如用到医疗领域去做内窥手术的音视频系统。

处在物联网的阶段,我们要拥抱“软件定义”,它有以下的好处:精细化管理每个终端、系统规模可以无线扩展、软件定义自由适应不同场景、布线极其简单、加固后的AV/IP网络固若金汤。

KANE ZHANG 从硬件思维到软件思维

易科国际副总裁、北京InfoComm品牌大使KANE ZHANG

我个人经过了几个历程,十几岁到二十几岁,出门跟别人谈的就是设备,拼的是设备。大约在2000年以后,发现音视频开始要向网络里去传输,开始去研究,学习了一个词叫“网络化”。现在大家对这个词见怪不怪,但在十年前,有谁会想到搞音视频的人要懂网络?包括现在也没有多少人真正懂。懂IT的人不懂AV,懂AV的人不懂IT,所以两者之间要互相学习,不能轻易地将所有问题丢给一边的人去解决。

最近这几年出现了一句话——“软件定义一切”,这当然就包括软件定义网络、软件定义会议、软件定义SDS等等。这里我给大家分享两个例子。比如解决啸叫问题:在调音台上把推子往下压一点,音量调小一点,就不啸叫了。这个思维的过程是硬件思维过程。也就是说我们通过人来操作设备解决了一个技术问题。

那么我们什么时候步入到软件思维呢?2010年时,我跟大家说迟早有一天在会议室的系统建设中,会把调音台淘汰掉,当时很多人都觉得不可能,但现在还有多少日常会议室在用调音台的解决方案呢?越来越多人接受了处理器。处理器为什么能够取代调音台?其实用的就是软件思维。也就是让一个系统能够自主的完成一个比较复杂的任务。

处理器解决啸叫问题比人手动解决容易得多。它可以现场监控声音每一个点的频率幅度,也就是把实域的信号变成频域的信号。比如说通过对比话筒检测到来自音箱和人声的4000赫兹的幅度已经已经非常接近了,那这时候可以在DSP里设定域值,当来自音箱的幅值接近这个域值,就自动地降低一点,这样永远都不可能啸叫。因为这套机制是自动的,我们管这个叫“算法”,有了算法之后,啸叫就不再是个问题。被软件定义的DSP处理器的硬件,从本质上跟调音台很接近,是用算法指挥硬件,让它更好地工作。

再比如摄像头,我们用摄像头捕捉画面,希望人在会议中,画面能精准跟踪到真正在发言的人。于是我们简单的通过话筒产生触发信号去指挥摄像头进行预设位的调用。但在实际的使用过程中发现有非常严重的问题。比如:杯子的声音,翻纸的声音,以及与会者咳嗽的声音等都会严重的干扰摄像机的运转。画面会频繁的变动,甚至转向没有人讲话的位置。这些都是系统的误操作。

如何才能让画面能够像电视导播那样精准的指向讲话者呢?这就需要有软件思维了。我们要通过算法精准的识别出不同的场景。比如:一个讲话,多个人讲话,噪音,与会者的顺嘴搭音等等。然后再根据电视导播规则对算法进行优化。比如:画面的转换不能过于频繁,尽量避免Zoom

out的效果(比如可以通过转场进行掩饰)等等。这样通过一个算法就可以基本实现比较精准的大会议室的摄像跟踪了。

我们接下来给大家做个简单的演示。我邀请了两位同事在一间会议室中。通常与会者都要对着话筒讲话,远端的人才能听清。如果远离话筒,远端的人就听不见,离近了,就会造成非常严重的近讲效应。远程的人听到的声音就会非常模糊。这是会议室中非常常见的现象。但如果采用软件思维,我们就可以利用,AGC,和

comp/limiter这两个模块中的算法来解决这个难题。正如大家所看到的,如论是男生还是女生,无论是离远还是离近,声音都清晰可闻。这样就解决了单纯依靠硬件无法解决的问题。

我们再让两位同事一起演示摄像跟踪的功能。女生讲话的时候,尽管男生也不是搭话,但由于主讲是女生,镜头并没有切换到男生,当男生持续讲话的时候,镜头就转过去了。远端的我讲话的时候,会具有高优先级,也就是说,尽管本地仍然有人讲话,只要我也就是远端在讲话,镜头就会呈广角以便看到所有的与会者。当然我们也可以将本地会议室的领导席设为最高优先级。这样即便在领导发言的时候有其他人在讨论,镜头中也会锁定领导的画面。这段演示视频已经在慧聪音响灯光网的微信公众号。如果大家有兴趣,欢迎关注观看。

兆翦与IT融合是AV行业发展之路

中国演艺技术协会专家、QSC北亚区技术经理兆翦

我主要从结构上讲一下对“软件定义AV”的理解。“软件定义一切”表明了我们从纯粹依靠物理的设备实现一些功能,逐渐转换成以软件为主实现一些功能。像我们比较熟悉的电影,早期都是用一些实景去拍摄,后来开始逐步转向数字动画的制作,再后来完全可以虚拟化。也就是说,电影可以呈现的场景完全在于你脑子里能想出来什么。这些主要是依靠软件的实现,而不是单纯依靠硬件就能实现的。

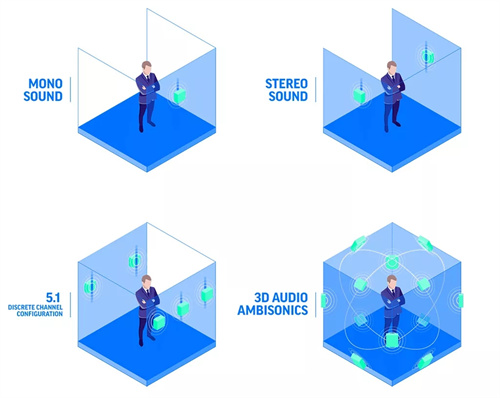

在AV这个行业里面,我们比较熟悉的对声音的处理,最早有单声道的声音,后来发展到立体声,5.1声道再到现在的所谓沉浸声,这个发展是典型的从硬件到软件移动的过程。

基于通道(channel based)→基于目标(object based)

尤其是在前三个里面,从单声道到立体声,只是把扬声器从一只变成两只,我们可以通过调音台的声像旋钮把声音分开,录音的时候也可以采用多角度的录音。到5.1声道的时候,声音有很多就不是原始的声音,而是一种声效。声音的内容是在电脑里生成出来的,然后通过计算机模拟之后,把它续到这个不同的方向上。但是不论哪一种,我们都把它叫基于通道的声音,所有声音的发声点都在喇叭。

但现在电影院使用的沉浸音,就不是基于通道了,它的声音的发声点是一个虚拟的空间点,跟实际的喇叭摆放位置相关性不是特别强。在沉浸式的环境里面使用的喇叭数量可以在16到64个之间的任意喇叭数量都可以,都能够还原录音师创作这个声音时,呈现出来的景象。

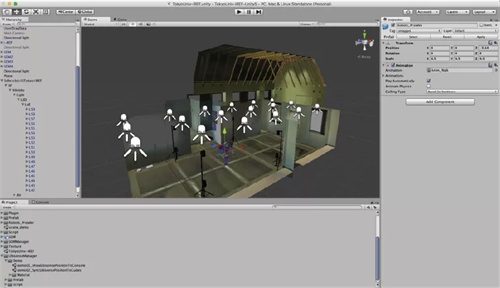

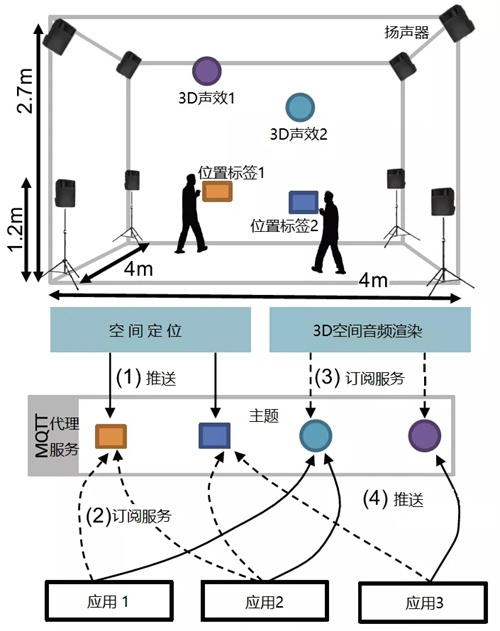

从沉浸音再往前发展,就有交互式的声音体现。比如日本在2014年在小房间里做了一个实验。声像是依靠在房间四周摆放的若干喇叭来实现,它所呈现的效果是在互联网的另一侧的一个服务器里面完成,展示一个蜻蜓在天上飞的效果。但是这个声音不是沿着固定的路线在房间内移动,不像我们看电影那样,有直升飞机,或者是一个昆虫,从左飞到右,而是它取决于听音者所在的位置。每一个听音者在这个房间里面会有一个信号标,这个信号标会表现出这个听众所在的位置,计算机会根据这个人所在位置传回到远端服务器,来实时渲染出该有的声音,再送回到现场播放。

所以当这个人前后左右移动的时候,声音效果是变化的。整个过程的变化完全是靠虚拟的方法来形成,靠计算机、靠软件来实现的。在这种应用的场景里面,我们硬件比如说信标、话筒、扬声器、显示器等,其实都已经退化成一个边缘的硬件设备。这种交互式体验,也是元宇宙声学里的一种应用场景,当然我们现在离元宇宙音频的使用还差相当一段距离,但是发展思路是这样,跟听众所处的位置有关系,跟场景有关系,而且一定是交互的。

在软件定义AV的世界里,可以把图像和声音大致分成三层来理解。第一层是应用层,也就是你想实现什么样的效果。第二层是服务层,它可能在云端,也可能在本地,是由一个服务器根据观众的位置信息来对影音效果进行实时的渲染,当然你必须要有高速的数据传输通道。第三就是基础设施,就是我们所说的硬件,比如功放、喇叭、摄像机和显示器等等。在软件定义AV的世界里,我们当前所操作的这些硬件在未来会只剩下三类,其他的恐怕通通被淘汰:第一个就是AD/DA转换器,它负责信号的采集和回放,喇叭、摄像头、显示器等都属于这块。第二类就是边缘计算,比如声卡、显卡之类。第三类就是传感器。

在传统音视频系统里面,我们的用户所面临的痛点是什么?首先就是音频、视频、中控,AVC之间的互动操作,如果想做到无缝连接,这个任务是非常艰巨、挑战是巨大的,所付出的时间等各方面的成本非常多,而且功能越多、设备越多,设备的故障点越多,这是AV系统的痛点。

那么IT

行业的痛点是什么?第一个就是客户体验,如果客户体验不佳,再高科技也没用。再者就是怎么把IT和AV更好地融合,当我们把IT和AV的设备都采用标准的工业化产品,比如同样采用电脑服务器、以太网交换机、云端服务器,数据库等等,那它们的可靠性和互通性就好很多。

有关集成方面东西,以前是音频、视频和中控之间互相集成,其实AV和IT的集成更重要,若AV系统使用数据库、双向通讯、云端管理的方式,更接近IT的思路,则更容易让AV和IT做进一步的融合。所以我们从设备的功能、系统集成的标准,以及云端的管理三个角度来同时向一个方向走的时候,AV和IT的运营团队将会发现,他们使用相同的工具,相同的页面和相同的管理方式就可以管理同样一套东西了。到那个时候,AV和IT才能够真正融合起来,我想这也是我们AV行业的向前发展之路。

KANE ZHANG怎样紧跟趋势?

这要两个方面去考虑,第一我们需要具备什么样的素质才能走这条路?第二是如何拓宽眼界?第一个问题要求我们不仅要懂客户端的需求,还要懂硬件的深层机制、要懂软件的基础架构、最重要的要懂如何呈现,也就是具体的应用场景。第二个问题,以我个人的经验,最大的帮助就是多跟行业的技术专家在一起交流。

兆翦难点在哪?

首要问题是克服心理上的那道坎。因为我们几十年来行业都是从硬件走过来的,如果突然把这些东西电脑化、云端化、虚拟化,我们熟悉的器材都变成边缘性的东西,在心理上不好接受,也很难认可软件化之后会有多好,我相信这是一个心理上的坎。但无论喜欢与否,觉得它好还是不好,在软件定义的世界,IT主宰AV行业一定是未来的一个趋势,不可改变。

免责声明:凡注明来源本网的所有作品,均为本网合法拥有版权或有权使用的作品,欢迎转载,注明出处。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

+ 更多资讯热度榜

+ 更多企业访谈

+ 更多慧聪原创

+ 更多技术文章

+ 更多工程案例